AdaBoost算法补充

1.AdaBoost的回归问题

此处以AdaBoost算法为准

1.误差率

2.弱学习器的权重系数

3.更新权重

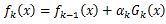

第k+1个弱学习器的样本集权重系数为

Z_K时规范化因子:

最终的强回归器为:

2.AdaBoost算法的正则化

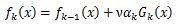

为防止AdaBoost过拟合,通常会加入正则化项,这个正则化项通常称为步长,定义为ν,对于前面弱学习器的迭代

如果加上前面的正则项,有:

ν的取值范围为0<ν<1,对于同样的训练集学习效果,较小的ν意味着需要更多的弱学习器迭代次数,通常用步长和迭代最大次数一起来决定算法的拟合效果。

3.AdaBoost小结

理论上任何学习器都可以用于Adaboost,但一般来说,使用最广泛的Adaboost弱学习器是决策树和神经网络。对于决策树,Adaboost分类用了CART分类树,而Adaboost回归用了CART回归树。

Adaboost的主要优点有:

(1)Adaboost作为分类器时,分类精度很高;

(2)在Adaboost的框架下,可以使用各种回归分类模型来构建弱学习器,非常灵活;

(3)作为简单的二元分类器时,构造简单,结果可理解;

(4)不容易发生过拟合。

Adaboost的主要缺点有:

对异常样本敏感,异常样本在迭代中可能会获得较高的权重,影响最终的强学习器的预测准确性。