AdaBoost算法流程与优化

1.AdaBoost分类问题的损失函数优化

1 | AdaBoost的弱学习器权重系数公式和样本权重更新公式,可以从AdaBoost的损失函数推导出来。 |

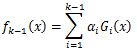

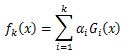

1 | 第k轮学习器为: |

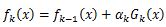

1 | 可以得到 |

可以看出强学习器时通过前向学习算法一步步得到的。

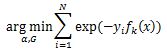

AdaBoost损失函数为指数函数,定义损失函数为:

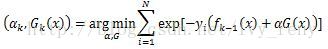

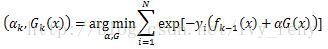

利用前向分布学习算法的关系可以得到:

令Wki=exp(-YiFk-1(x)),他的值不依赖于α,G,因此与最小化无关,仅仅依赖于fk-1(x),随每一轮迭代而改变。将这个式子代入损失函数,损失函数转化为